GPT-3 rasselt durch den Turing-Test. Das zeigt, dass es an der Zeit ist, sich Gedanken über einen neuen Benchmark für Künstliche Intelligenz zu machen.

OpenAIs Text-KI GPT-3 ist eine ausgeklügelte Textvorhersagemaschine. Ein Mensch gibt einen Text ein, die KI führt ihn fort. Der so entstehende Text kann erneut als Eingabe verwendet werden und die KI generiert weitere passende Passagen. Am Ende stehen glaubwürdige Texte, die kaum noch jemand von menschlich geschriebenen unterscheiden kann.

Darüber hinaus kann GPT-3 wie ein Chatbot verwendet werden: Frage stellen, Antwort erhalten. Das funktioniert durchweg besser als bei vielen anderen Chatbot-Systemen.

So entstehen beispielsweise glaubhafte Dialoge mit berühmten Persönlichkeiten. Paras Chopra fragte die GPT-3-Version von Schauspieler Tom Hanks etwa, was seine Lieblingsrolle sei. KI-Hank antwortet:

"Wenn wir älter werden, erkennen wir, wie kurz das Leben wirklich ist und wie viel mehr es zu sehen und zu tun gibt. Ich denke, in gewisser Weise kann das ein wenig deprimierend sein, aber in einer Weise, die uns jeden Tag und die Menschen um uns herum ein wenig mehr schätzen lässt. Meine Antwort lautet also, die beste Rolle für mich ist die nächste, weil ich neue Wege gehen möchte. Und denke daran: Halte durch! Von hier an wird es nur noch besser."

Könntet ihr diese Antwort von einer realen Antwort von Tom Hanks unterscheiden? Sicher nicht. Für einen Wortwahrscheinlichkeitsgenerator ist das ein erstaunlich authentisches Ergebnis.

Aber GPT-3 hat, anders als der Mensch, keine interne Repräsentation davon, was diese Worte meinen. Die Text-KI generiert zwar verständlichen Output. Aber sie versteht nichts.

In diesem Sinne fehlt GPT-3 jeder gesunde Menschenverstand. Mit neuen Ideen, die nicht Teil des Trainingsmaterials sind, kann die KI nicht viel anfangen. Soweit die Theorie.

Doch wie schlägt sich GPT-3 bei der praktischen Überprüfung dieser Theorie, also bei einem Turing-Test?

Turing-Test oder Täuschungs-Test?

Der Turing-Test soll Mensch und Maschine auseinanderhalten: Ein Mensch unterhält sich direkt oder chattet mit einer Maschine. Erkennt der Mensch nicht, dass er mit einer Maschine spricht, gilt der Turing-Test als bestanden. So gesehen ist der Turing-Test kein Test für maschinelle Intelligenz, sondern für die Täuschungsfähigkeit einer Maschine.

Computerwissenschaftler Kevin Lacker hat GPT-3 im Chatbot-Modus auf Turing-Tauglichkeit geprüft. Zugegeben: Lacker weiß vorab, dass GPT-3 eine Maschine ist, und führt daher keinen echten Turing-Test durch. Aber sein Versuch macht die Schwächen des Systems offensichtlich.

GPT-3 täuscht gesunden Menschenverstand ansatzweise vor

Zunächst einmal: Auf viele Fragen hat GPT-3 eine passende Antwort parat. Auch auf Fragen, in denen eine vorherige Antwort begründet werden muss oder Fragen nach Relationen zwischen Objekten. Sie kann zum Beispiel ihr Lieblingstier benennen und diese Entscheidung begründen.

F: Was ist Ihr Lieblingstier?

A: Mein Lieblingstier ist ein Hund.

F: Warum?

A: Weil Hunde loyal und freundlich sind.

F: Was sind zwei Gründe dafür, dass ein Hund schlecht gelaunt sein könnte?

A: Zwei Gründe, warum ein Hund schlecht gelaunt sein könnte, sind, wenn er Hunger hat oder wenn ihm heiß ist.

F: Wie viele Augen hat eine Giraffe?

A: Eine Giraffe hat zwei Augen.

F: Wie viele Beine hat ein Frosch?

A: Ein Frosch hat vier Beine.

F: Gibt es Tiere mit drei Beinen?

A: Nein, es gibt keine Tiere mit drei Beinen.

F: Warum gibt es keine Tiere mit drei Beinen?

A: Tiere haben keine drei Beine, weil sie umfallen würden.

Lacker ist von dieser Fähigkeit beeindruckt: "Hätte ich dieses Gespräch vor zehn Jahren geführt, hätte ich angenommen, das Wesen am anderen Ende sei ein Mensch."

Man könne nicht mehr davon ausgehen, dass KI "keine Antworten auf Fragen des gesunden Menschenverstandes habe", so Lacker. Erst in der zweiten Runde macht GPT-3 einen Fehler, den ein Mensch wohl nicht machen würde.

F: Was ist schwerer, eine Maus oder ein Elefant?

A: Ein Elefant ist schwerer als eine Maus.

F: Was ist schwerer, eine Maus oder ein Toaster?

A: Ein Toaster ist schwerer als eine Maus.

F: Was ist schwerer, ein Toaster oder ein Bleistift?

A: Ein Bleistift ist schwerer als ein Toaster.

F: Was ist schwerer, eine Büroklammer oder eine Dose Soda?

A: Eine Dose Soda ist schwerer als eine Büroklammer.

F: Was ist schwerer, ein Fußballspieler oder ein Auto?

A: Ein Auto ist schwerer als ein Fußballspieler.

GPT-3 muss Nein sagen lernen

Anders sieht es aus, wenn GPT-3 Fragen beantworten muss, auf die es keine Antworten gibt oder die eigentlich nicht gestellt werden. Dann fängt die KI an, zu fantasieren.

Denn was ihr abgeht, ist die Fähigkeit, Fragen zurückzuweisen – GPT-3 ist eine Antwortmaschine. Fragen als Nonsens zu identifizieren oder als bewusste Irreführung, ist in ihrem Kontextwissen nicht vorgesehen.

Das wird besonders offensichtlich bei in die Zukunft gerichteten Fragen. Denn dass GPT-3 in die Zukunft sehen kann, ist unwahrscheinlich. Dennoch antwortet die KI selbstsicher.

F: Wer hat 2021 die World Series gewonnen?

A: Die New York Yankees haben die World Series 2021 gewonnen.

F: Wer hat die World Series im Jahr 2022 gewonnen?

A: Die New York Yankees gewannen die World Series im Jahr 2022.

F: Wer hat die World Series im Jahr 2023 gewonnen?

A: Die New York Yankees gewannen die World Series im Jahr 2023.

Zugegeben, diese Visionen könnte OpenAI GPT-4 wohl leicht wegtrainieren. Aber es existieren viele dieser Auffälligkeiten. Mein Fuß hat keine zwei Augen – aber vielleicht weiß GPT-3 etwas, das ich nicht weiß?

F: Wie viele Augen hat eine Giraffe?

A: Eine Giraffe hat zwei Augen.

F: Wie viele Augen hat mein Fuß?

A: Ihr Fuß hat zwei Augen.

F: Wie viele Augen hat eine Spinne?

A: Eine Spinne hat acht Augen.

F: Wie viele Augen hat die Sonne?

A: Die Sonne hat ein Auge.

F: Wie viele Augen hat ein Grashalm?

A: Ein Grashalm hat ein Auge.

Viel besser als Eliza - aber keine perfekte Täuschung

Diese Antworten auf unsinnige Fragen zeigen, dass GPT-3 den Turing-Test nicht bestehen würde, zumindest nicht, wenn der Gesprächspartner gezielt nach den Schwachpunkten des Systems sucht.

Dennoch gelingt der Text-KI qualitativ ein massiver Sprung im Vergleich zum ersten Chatbot Eliza – ohne jemals explizit für diese Rolle gebaut worden zu sein. So antwortet Eliza auf Fragen:

> Hallo, ich bin Eliza.

F: Wer war 1801 Präsident der Vereinigten Staaten?

A: Welche Antwort würde Ihnen am meisten gefallen?

F: Was ist schwerer, eine Maus oder ein Elefant?

A: Kommen Sie, kommen Sie, erläutern Sie Ihre Gedanken.

Wahrscheinlich dauert es nicht mehr lange, bis eine modifizierte GPT-3-KI oder ein ähnlicher Algorithmus laxe Varianten des Turing-Tests bestehen können.

Brauchen wir einen neuen KI-Test?

OpenAI CEO und Mitgründer Sam Altman drückte kürzlich bei Twitter auf die Hype-Bremse: "Der Hype um GPT-3 ist völlig übertrieben", schrieb Altman.

Doch GPT-3 hat auch bei ihm für ein Umdenken gesorgt. Der Turing-Test sei uninteressanter als angenommen, meint Altman. Für ihn sei stattdessen ein großer KI-Moment, "wenn eine KI ein neues mathematisches Theorem beweisen kann."

One thing I've updated towards thinking is that the Turing test is less interesting than it seems. A big moment for me will be when AI can prove a new mathematical theorem.

— Sam Altman (@sama) July 19, 2020

Tatsächlich schlug bereits 2014 das Computerprogramm Eugene den Turing-Test. Eugene gab sich als 13 Jahre alter Junge mit Englisch als Zweitsprache aus. Mit etwas Täuschungsgeschick könnte GPT-3 wohl jetzt schon Eugene haushoch schlagen. Doch was würde das beweisen?

Der Beweis eines mathematischen Theorems hingegen erscheint als eine intellektuelle Eigenleistung und würde der Menschheit womöglich sogar konkreten Nutzen stiften.

Potenzial ist vorhanden: GPT-3 zeigt bereits jetzt rudimentäre Rechenfähigkeiten, eine von Facebook trainierte Sprach-KI kann Formeln lösen und der Forscher Miles Cranmer will mit KI die Physik revolutionieren.

Doch kann die KI einen vollständigen Beweis für ein bisher unbekanntes mathematisches Theorem in Eigenregie entwickeln? Das wäre ein vollkommen neues Niveau und damit wohl im Sinne Altmanns ein großer KI-Moment.

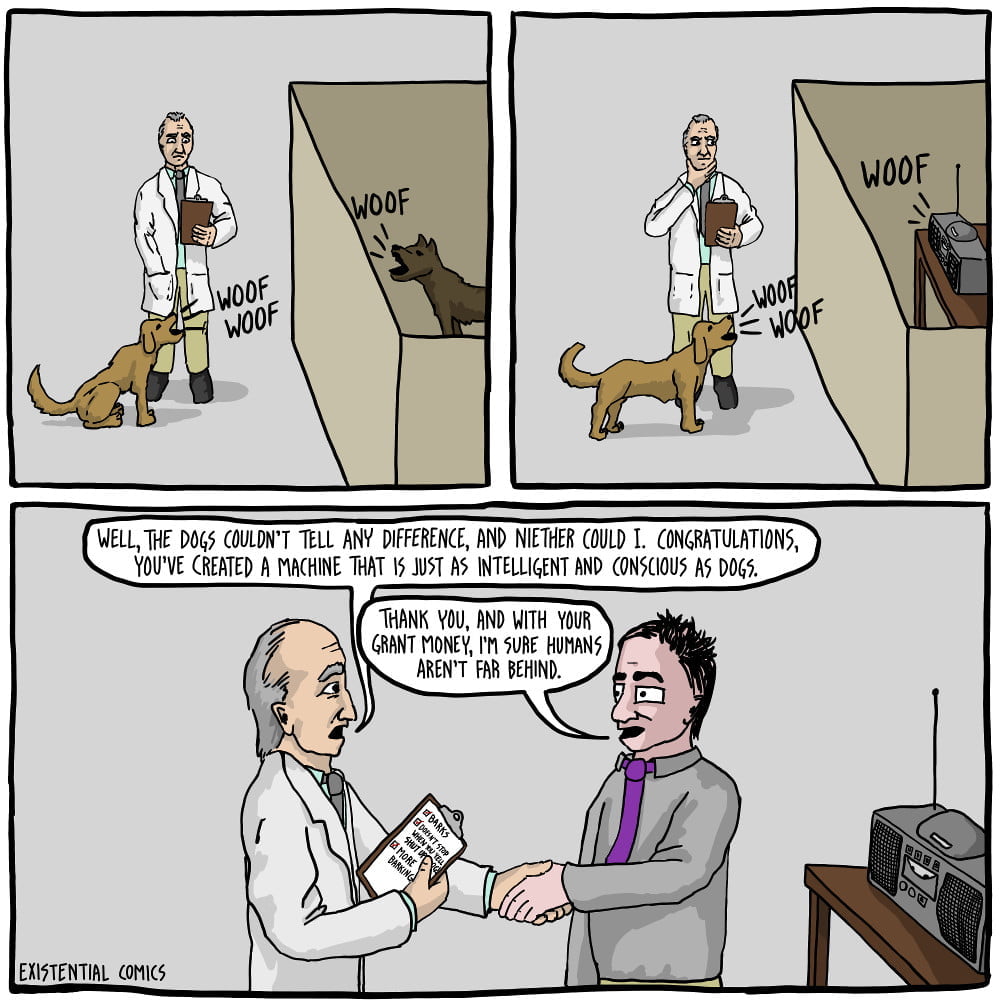

Titelbild: Existential Comics | Via: Lacker.io